更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

【closerAI ComfyUI】低显存福音!通义万相VACE-14B GGUF量化模型!低配置能出高质量,提高使用灵活性!冲!

大家好,我是Jimmy。wan2.1 VACE 14B与1.3B 的视频生成与编辑模型的推出,引起开源界社区热议,直接高速推进视频生成的步伐:

震撼开源!开源界福音!通义万相 Wan2.1-VACE 正式开源!集视频生成与编辑大统一模型!能力强大效果炸天!

但是高质量的大统一视频生成与编辑模型带来就是高配置与长时间的困扰,社区也在努力优化迭代来解决这些问题,像VACE加速LORA Cuasvid:

【closerAI ComfyUI】显存救星!300多M的LORA带来10倍加速!wan2.1-VACE大统一模型的加速器!冲!

最高可提升VACE视频生成10倍的速度。

这两天,社区大神QuantStack发布了Wan2.1-VACE-14B-GGUF版本,能在较低的配置资源上完成高质量的VACE视频生成。这真的是低显存玩家的福音呐!无脑直冲一波。

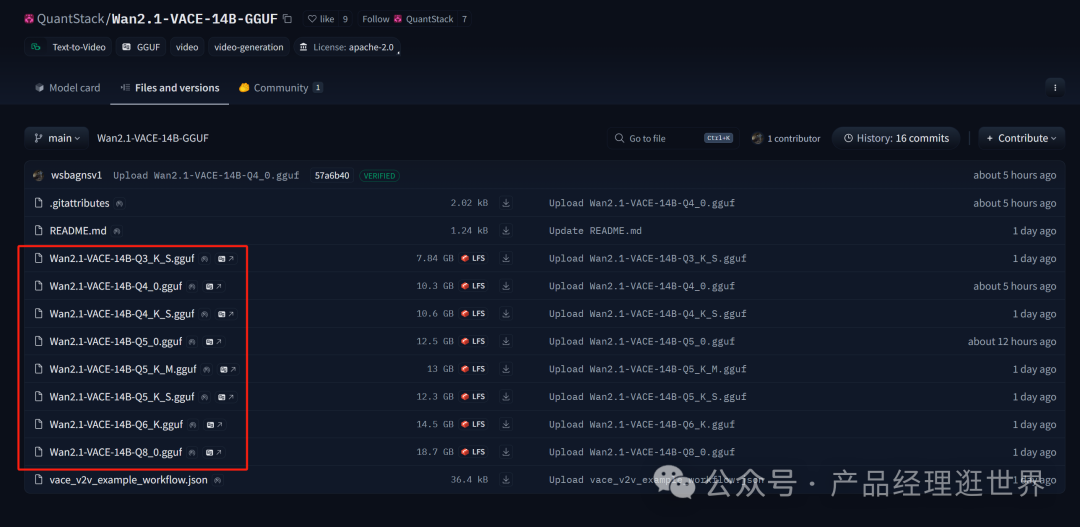

Wan2.1-VACE-14B-GGUF版本

地址:https://huggingface.co/QuantStack/Wan2.1-VACE-14B-GGUF/tree/main

镜像地址:https://hf-mirror.com/QuantStack/Wan2.1-VACE-14B-GGUF/tree/main

目前开源了:Q3~Q8的GGUF版本,如上图示。

每个版本的情况概括如下:

Q8_0(8 - bit,接近原版精度)

Q6_K(6 - bit,平衡精度与速度)

Q5_K_M(5 - bit,推荐默认选择)

Q4_K_M(4 - bit,性价比最优)

Q3_K_M(3 - bit,极低显存,精度损失较大)

VACE - 14B GGUF的优势

将VACE - 14B模型转换为GGUF格式后,结合了两者的优势,既能够利用VACE - 14B强大的视频生成和编辑能力,又能发挥GGUF格式在模型存储、加载和推理方面的高效性。

这使得在资源受限的设备上也能相对流畅地运行该模型,实现视频创作和编辑任务,例如在消费级GPU或移动终端上,用户可以借助量化后的VACE - 14B GGUF模型进行视频的生成、编辑等操作,降低了硬件门槛,提高了使用的灵活性。

不过,由于GGUF量化存在精度损失,可能会对VACE - 14B原本的视频生成质量产生一定影响,具体的影响程度取决于所采用的量化参数和模型本身对量化的敏感度。

使用方法

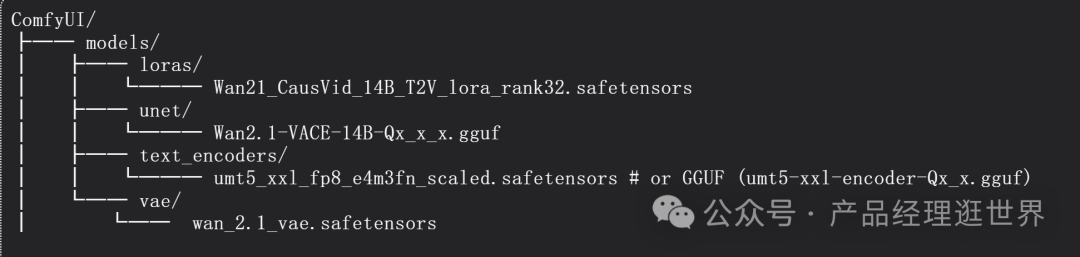

大家根据上述的说明下载对应模型即可。下载后放以下路径中:ComfyUI/models/unet中。

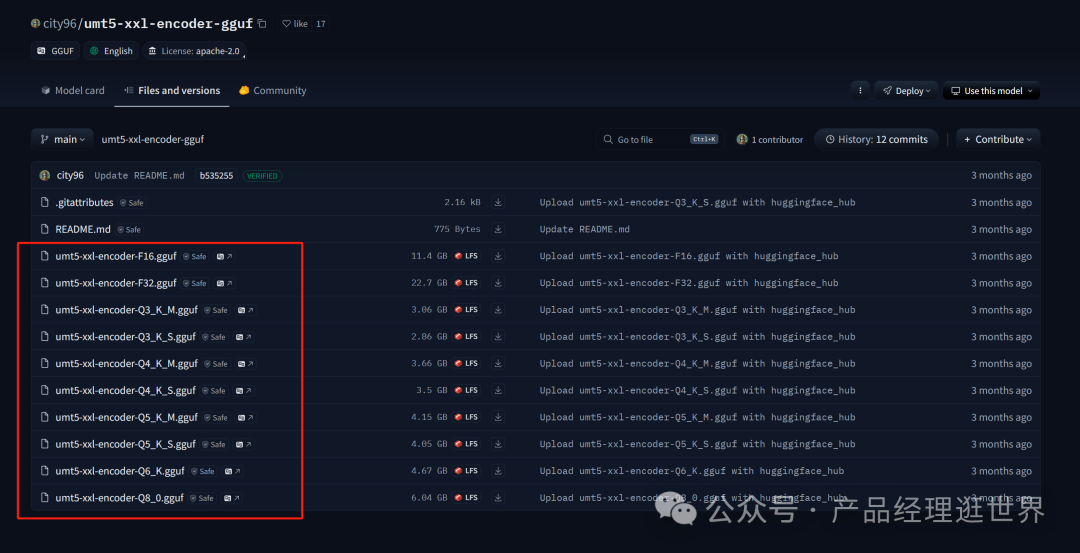

同时,更新GGUF插件节点,并下载好对应版本的的encoder GGUF模型:相信有些小伙伴已下载过。以下是链接:

https://huggingface.co/city96/umt5-xxl-encoder-gguf/tree/main

下载后放comfyui/models/text_encoders下

一些其它需要的模型以及放置目录如下图示:

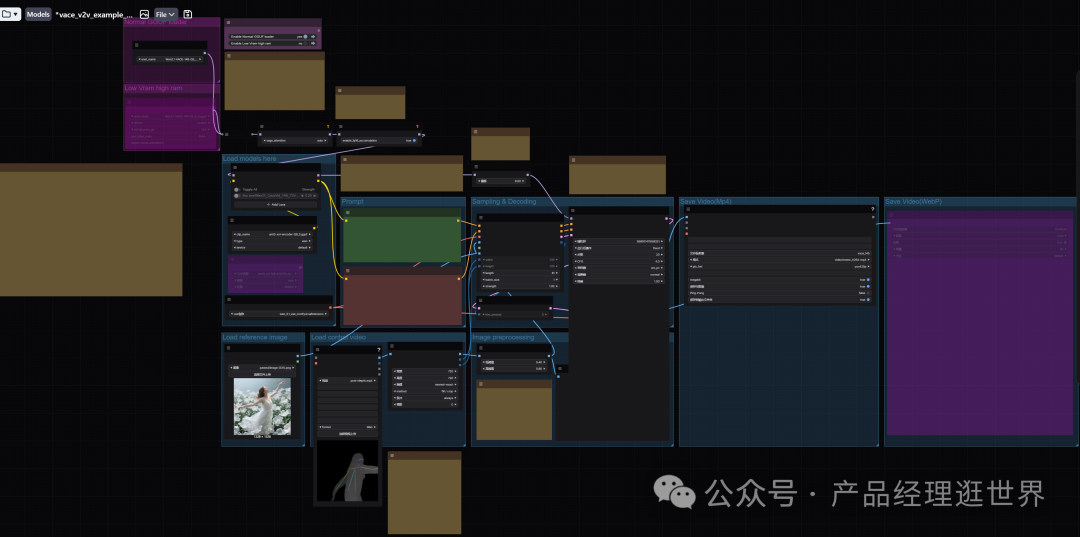

加载工作流:

加载好模型,加载一张图:

加载一个视频:

示例结果如下:

本地算力不够怎么办?

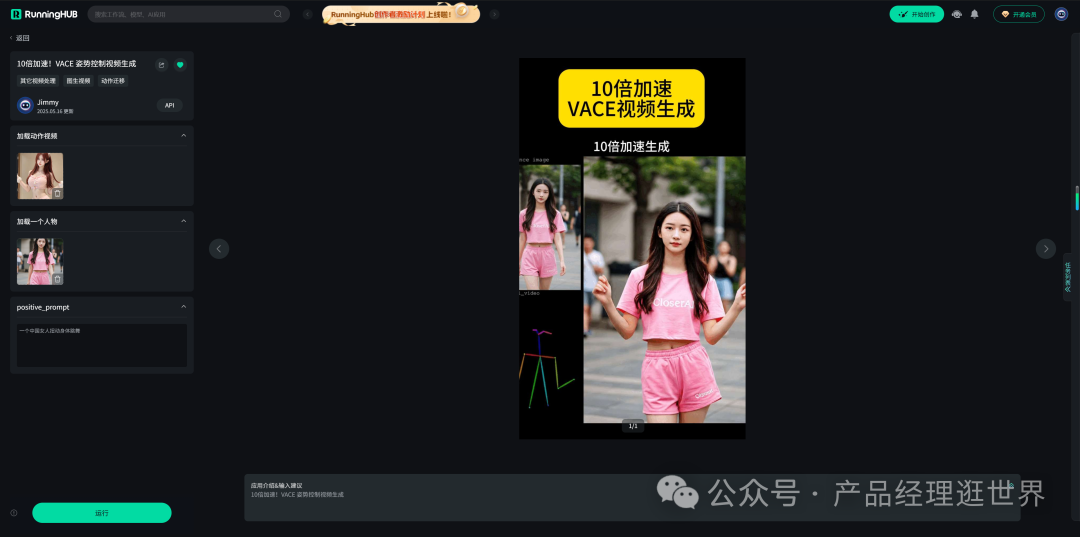

如果本地设备算力不好的小伙伴,推荐使用线上comfyUI来运行体验:runninghub.cn

runninghub.cn 10倍加速VACE视频生成体验地址:

https://www.runninghub.cn/ai-detail/1923203802458222593

注册地址:https://www.runninghub.cn/?utm_source=kol01-RH151

通过这个链接第一次注册送1000点,每日登录送100点

最后几句:

VACE - 14B GGUF将两者结合,既保留VACE - 14B强大的视频生成和编辑能力,又具备GGUF格式高效存储、快速加载和量化优势,可在资源受限设备上运行,降低硬件门槛,推动视频创作和编辑技术发展!

以上是VACE-14B GGUF量化模型的介绍与使用方法和测试。大家可以根据以上介绍和思路进行尝试搭建。

当然,也可以在我们closerAI会员站上获取对应的工作流和对应模型(查看原文)。

以上,既然看到这里了,如果觉得不错,随手点个赞、在看、转发三连吧,如果想第一时间收到推送,也可以给我个星标⭐~谢谢你看我的文章,我们,下次再见。

>/ 作者:JimmyMo

更多AI前沿科技资讯,请关注我们:

closerAI-一个深入探索前沿人工智能与AIGC领域的资讯平台

主题授权提示:请在后台主题设置-主题授权-激活主题的正版授权,授权购买:RiTheme官网

评论(0)